想要好好做网站的搜索引擎优化要做的有很多,我们可以分成站内SEO,站外SEO 和 技术SEO 这三大板块,想要简单的了解一下,可以看看我之前出的网站SEO基础设置教程。

这里我们一起来看看通常在站内SEO优化最常见的一些错误。

网站内容质量

不管你怎么做搜索引擎优化,都是在围绕一个主题,就是你的网站内容。

我相信你一定有读过一篇文章,然后想,“我好像在哪看到过”。根据 SEMRush 一项调查,66% 的网页存在重复内容问题,这会对我们的网站排名有影响。谷歌非常重视内容的质量,所以内容的原创性、独特性和相关性非常重要。当存在重复内容时,Google 会选择它认为”最佳”的页面将其包含在搜索结果中,其他的重复页面可能会被完全删除掉。

除了重复内容的问题,我们还可能遇到这两种情况:

1. 内容精简 (Thin Content)

内容精简是指为用户提供很少价值的内容,要么是因为内容缺乏深度,要么是因为它都是广告,要么是因为它是重复的文章,解决不了用户的需求。

一个文章如果持续几个月都未收到SEO流量访问就视为Thin content。

2. 关键词蚕食(Cannibalization)

Cannibalization是指几个页面互相竞争相同的查询。换句话说,你网站的内容A和内容B正在竞争,导致CTR被分配,减少了转换和降低内容的价值和权威。

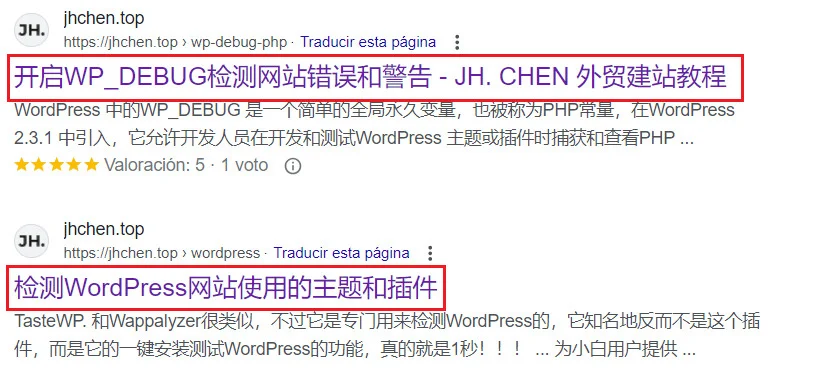

文章标题名

在搜索引擎优化排名里,文章的标题名字非常重要,因为这是用户在进行互联网搜索时首先看到的内容。

- 标题太短可能会限制页面对多个关键字进行排名

- 带有多个关键字的长标题可能会导致同类化 (cannibalization) 问题

- 防止重复的页面标题,这会当它们都出现在搜索引擎结果中(serps)时,用户很难确定想去哪个页面。

标题层次结构

从 H1 到 H6 的所有标题都可以用作SEO元素。

读者喜欢浏览网站的内容,可以在文章开始时添加一个内容目录(Table of content)并用链接锚点指定到各自区域,这样可以让用户们决定阅读哪些部分。 如果不注意标题,用户很难找到他们需要的信息,他们可能会直接退出你的网站。

通常是建议每个页面和文章把最重要的信息放在顶部,将最不重要的信息放在底部。另一个需要注意的错误是重复的 H1 标头。 此标记可帮助用户和搜索引擎快速了解他们可以在文章上找到哪些内容。只能有一个H1,否则引擎很难区分哪个最适合给搜索查询,并导致关键宇蚕食问题。而且还必须注意它们的组织方式。不要从 H1 跳到 H3。正确的顺序是 H1、H2、H3 等。

过长/过短/空的元描述

元描述不是直接影响SEO定位的因素,但是可以让我们的搜索引擎结果更有吸引力并导致点击次数和点击率的增加。

谷歌为桌面端设置了大约 155 个字符的限制,为移动设备设置了 120 个字符的限制(只是一个近似值,因为这个是用像素为单位计算的),我们可以充分利用他们分配给我们的空间来总结和介绍我们的内容。

网站语言

这只适用于你的网站有多种语言。

有一种莫名的误解,做多语言网站有人认为只要翻译网站中最重要的部分,他们就可以实现良好的 SEO 优化。这是大错特错的,一定要整个网站都翻译。

一种语言的产品或服务的相同关键词或搜索意图在另一个国家/地区可能不具有相同的相关性,差别可能会是天差地别的,更不用说自动翻译器对翻译的质量,虽然这些类型的工具可以节省我们的工作很有吸引力。

记住正确实施 hreflang 标签,例如:

- 中国=”cn-CN”

- 西班牙 =”es-ES”

- 马来西亚 =“my-MY

这样搜索引擎就会明白内容是在什么国家面向什么市场。

图片缺少ALT TEXT

不给网站上的图片写替代文本是大多数人经常犯的错误。

替代文本描述图片中的内容和在页面上的功能。 它有助于 Google 了解用户看到的内容以及它与其余内容的关系,如果只是装饰图片并不需要写alt。

它还可以帮助视障人士了解图片包含的内容,同时也是获得更多关键字排名的机会。它还可以让你出现在 Google 图片的搜索结果中。

关键词和搜索意图的过度优化

许多新品牌/新网站痴迷于在他们的市场中争夺短尾关键词,这完全是浪费时间和金钱的作死操作,这些时间和金钱完全可以用于其他更有成效的任务,例如搜索长尾词。

的确,短尾关键词的搜索量要高得多,但它们也很难获得排名,因为你所在行业中排名靠前的所有企业都在做短尾关键词。与其加入那场艰苦的战斗,建议寻找长尾关键词,这些关键词几乎或完全没有竞争,但有很多潜在流量。

另一个非常常见的错误是关键字的过度优化或关键字堆砌 (keyword stuffing) 它包括文章关键字超载,目的是操纵搜索引擎结果,以便出现在顶部位置,这样会导致文本变性,这些类型的做法会给用户带来差的体验,并受到谷歌的惩罚,这会对你网站的排名产生负面影响。

被 robots.txt 阻止的目录

Robots.txt文本是 SEO 中最具决定性的元素之一。 这是爬虫在访问网站时首先检查的内容,它会告诉它可以或不能爬取网站的哪些部分。

最常见的错误之一是忘记将文件放在正确的位置。 robots.txt 文件应始终位于网站的根目录中。 如果放在其他子目录下,爬虫在访问页面时就检测不到。我们还必须分析我们的页面是否被 robotstxt 阻止,如果是,爬虫将无法正确抓取或索引目录/页面的内容。

一个我经常被问的问题就是这个,“为什么我的网站不被收录?”,结果一看 Robots.txt 里面写着 disallow: /,无语…

4xx 错误 & 3xx 重定向

当用户访问页面时,服务器会返回一个 HTTP 状态代码,该代码向浏览器提供特定信息以执行特定操作。

当用户想要访问页面的信息时,可能存在某种问题,导致页面无法正确加载。这些类型的错误比许多人认为的更常见,我们得尽快识别并解决它们,以免它们对我们网站的搜索引擎排名产生负面影响。

HTTP 状态代码是由三位数字组成的数字,可帮助我们识别可能遇到的问题类型,详细的你可以去这篇 “HTTP状态码对搜索引擎优化的影响” 瞧一瞧。

网站速度 WPO

WPO 已成为任何页面搜索引擎优化策略中最重要的因素之一。

提供良好加载速度的网站更有可能在搜索引擎中获得更好的定位。

这是一个用脚想也明白的道理,谷歌自己也在 2010 年确认了网站的加载速度是搜索结果中的一个定位因素。 这个指的是从用户访问链接到网站完全加载、提供所有内容以便用户可以从第一次接触开始交互的时间。

分析你网站的所有 URL 是否经过优化非常重要,最好加载时间不超过 3 秒,这是用户愿意在页面内等待的最长时间,甚至更短。

有几种 WPO 技术我们可以用来加快加载速度: 清除页面缓存、网站开启缓存cache,优化 Javas-cript 和 CSS、图像优化、网站服务器优化等。